大数据分析等距组合与大数据服务器统计和处理描述说明的研究

随着信息技术的飞速发展,大数据已成为驱动社会进步和产业升级的核心要素。在此背景下,大数据分析的方法论及支撑其运行的计算机系统服务,特别是服务器集群的统计与处理能力,成为学术界与工业界共同关注的焦点。本文旨在探讨“大数据分析等距组合”这一创新性分析方法,并深入剖析大数据服务器在统计与处理过程中的核心机制与描述说明,以期为构建更高效、智能的计算机系统服务体系提供理论参考与实践指导。

一、 大数据分析等距组合的内涵与应用

“等距组合”概念源于数学与统计学,意指在保持特定度量或关系不变的前提下,对数据进行分组或整合。将其引入大数据分析领域,特指在分布式计算环境中,依据数据特征、计算任务复杂度或资源负载状况,将海量数据或计算任务动态、均衡地划分到不同的处理单元(如服务器节点)上,以确保整体处理效率最优、延迟最小、资源利用率最高的一种策略。

其核心价值在于:

- 提升并行效率:通过智能的数据/任务切片,使各计算节点负载均衡,避免出现“木桶效应”,最大化集群的并行处理能力。

- 保障分析质量:在分组时考虑数据的内在关联与分布特性(如时间序列的连续性、空间数据的邻近性),确保分析结果的准确性与一致性。

- 增强系统弹性:面对动态变化的数据流与计算需求,等距组合策略能够灵活调整资源分配,提高系统的自适应性与鲁棒性。

二、 大数据服务器的统计与处理机制描述

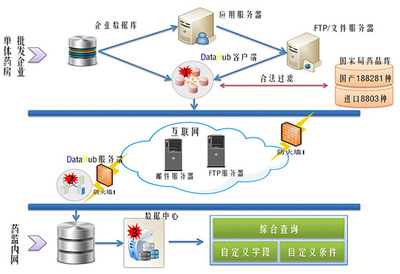

大数据分析任务的落地,高度依赖于后端强大的服务器集群。其统计与处理过程是一个复杂的系统工程,主要涵盖以下层面:

- 资源统计划分:服务器集群通过监控系统(如Prometheus, Ganglia)实时收集各节点的CPU、内存、磁盘I/O、网络带宽等资源利用率指标。基于这些统计信息,资源调度器(如YARN, Kubernetes)实施“等距组合”或类似策略,将计算任务(MapReduce, Spark Job等)调度到合适的节点上,实现资源的精细化管理与高效利用。

- 数据处理流水线:典型的大数据处理遵循“采集-存储-计算-可视化”的流水线。服务器集群负责:

- 分布式存储:利用HDFS、对象存储等技术,将数据分块冗余存储于多个节点,提供高吞吐量的数据访问能力。

- 分布式计算:通过Spark、Flink等计算框架,将分析任务分解为多个阶段(Stage),并在集群中并行执行。处理过程中涉及大量的Shuffle(数据混洗)、聚合等操作,其效率直接影响整体性能。

- 实时/批处理协同:现代大数据架构通常需要同时支持离线的批量统计分析(Batch Processing)和在线的实时流处理(Stream Processing),服务器集群需提供统一或集成的资源管理与任务调度能力。

- 性能监控与优化描述:对整个处理过程的性能进行持续监控与描述(Profiling)至关重要。这包括记录任务执行时间、各阶段数据量、资源消耗瓶颈等。基于这些描述性信息,系统管理员或自动化工具可以识别性能热点,优化数据分区策略(应用等距组合思想)、调整计算参数、扩容硬件资源,从而持续提升处理效能。

三、 计算机系统服务的整合与展望

将“大数据分析等距组合”的先进方法论与强大、智能的大数据服务器统计处理能力相结合,构成了现代计算机系统服务的核心。这种服务不仅提供裸机的计算与存储资源,更提供了一整套包含资源调度、任务管理、性能优化、安全管控在内的平台级能力。

未来研究方向包括:

- 智能化等距组合算法:引入机器学习技术,使数据/任务的分组与调度策略能够根据历史负载和实时状态进行预测与自我优化。

- 异构计算融合:在服务器集群中整合CPU、GPU、FPGA等异构计算单元,研究适用于混合架构的等距组合与任务调度策略,以应对AI模型训练等新型计算密集型负载。

- 云边端协同处理:随着边缘计算的兴起,研究如何将中心云的大数据服务器与边缘节点、终端设备进行协同,实现数据与计算任务的全局等距优化分布。

- 绿色低碳计算:在等距组合与资源调度中引入能耗指标,探索在保证服务性能的前提下,最小化数据中心整体能耗的绿色计算路径。

对大数据分析等距组合与服务器统计处理描述的深入研究,是提升计算机系统服务智能化、高效化水平的关键。这需要跨学科的知识融合与持续的技术创新,以应对日益复杂的数据挑战,充分释放大数据的潜在价值。

如若转载,请注明出处:http://www.xgkchina.com/product/41.html

更新时间:2026-02-24 21:14:21